Mô tả

NVIDIA HGX 8x A100: Nền tảng tăng tốc mạnh mẽ cho AI và ChatGPT

Thời gian vừa qua, chúng tôi đã có cơ hội tiến hành thử nghiệm với ChatGPT sử dụng hệ thống NVIDIA A100. Tuy nhiên, chi phí cao của GPU này, lên đến hơn 10.000 đô la mỗi chiếc, khiến cho không phải ai cũng có thể tiếp cận được. Để cung cấp thông tin cụ thể hơn, chúng tôi đã tìm hiểu khả năng của hệ thống NVIDIA 8x A100 trong việc cung cấp sức mạnh cho ChatGPT bằng cách khai thác dữ liệu từ kho lưu trữ STH.

Đối với những người chưa quen với NVIDIA A100, thì có thể hiểu đây là một GPU chuyên dụng được thiết kế cho hệ thống máy chủ, không giống như dòng GeForce của NVIDIA, được sử dụng phổ biến để chơi game. A100 được thiết kế đặc biệt để tích hợp chặt chẽ vào hệ thống mà không cần bất kỳ quạt tản nhiệt chủ động nào, nó tối ưu hóa cho các tác vụ điện toán hiệu năng cao (HPC) và trí tuệ nhân tạo, thay vì chỉ dùng để hiển thị hình ảnh 3D mượt mà cho các ứng dụng trò chơi. Các kết nối tốc độ cao được gọi là NVLink cũng có trong các phiên bản PCIe của GPU này nhưng chúng không được thiết kế cho mục đích chơi game.

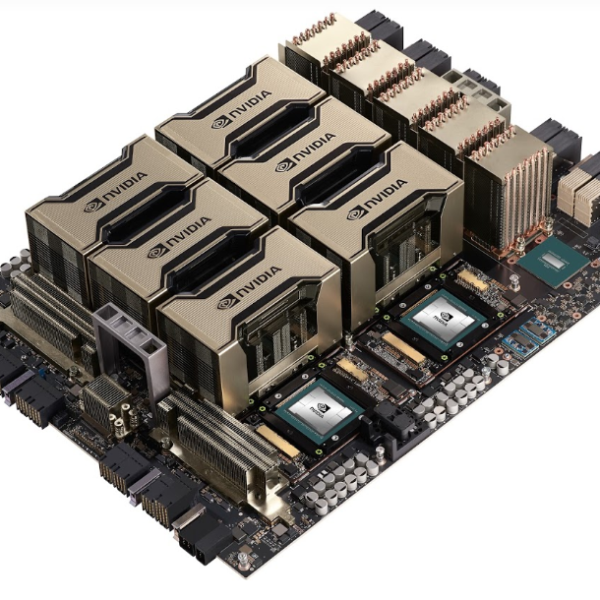

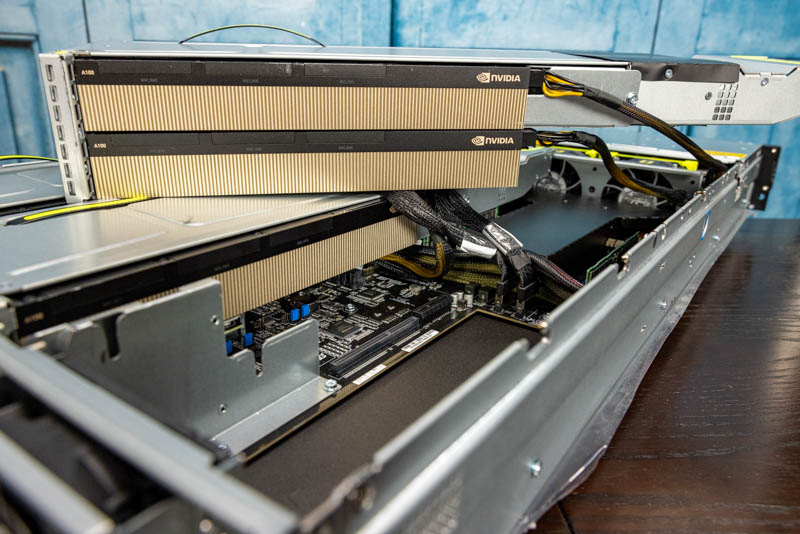

NVIDIA A100 không dành cho chơi game chính vì thiết kế của nó. Đối với hầu hết các hệ thống 8x NVIDIA A100, một thiết kế chuyên biệt dành riêng cho NVIDIA có tên là SXM4 được sử dụng để cho phép tiêu thụ lượng điện năng đáng kể từ các GPU. Các GPU phiên bản SXM4 có thể đạt đến 400-500W mỗi đơn vị, gấp đôi công suất của các phiên bản PCIe như các GPU chơi game. Tuy nhiên, các GPU A100 SXM4 không được bán riêng lẻ mà là một phần của hệ thống con có 4 hoặc 8 GPU do quá trình cài đặt khó khăn, hư hỏng bất kỳ cái chốt hoặc bộ phận tản nhiệt nào trên GPU có thể dẫn đến phá hủy hệ thống, và vì giá thành đắt đỏ của mỗi chiếc A100.

Các tản nhiệt quan trọng khác trên NVIDIA HGX A100 dùng để làm mát NVSwitches, đây là công nghệ kết nối tốc độ cao độc quyền của NVIDIA. NVSwitch cho phép giao tiếp cực nhanh giữa các A100 riêng lẻ trong một hệ thống.

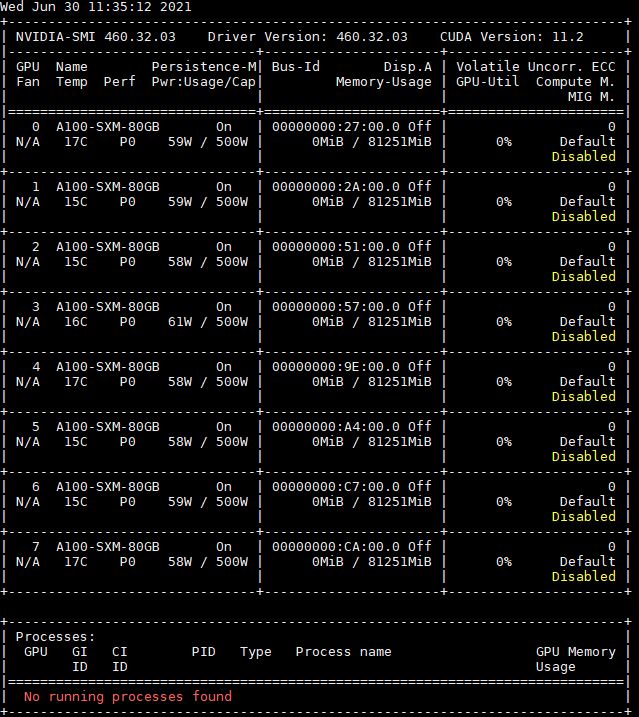

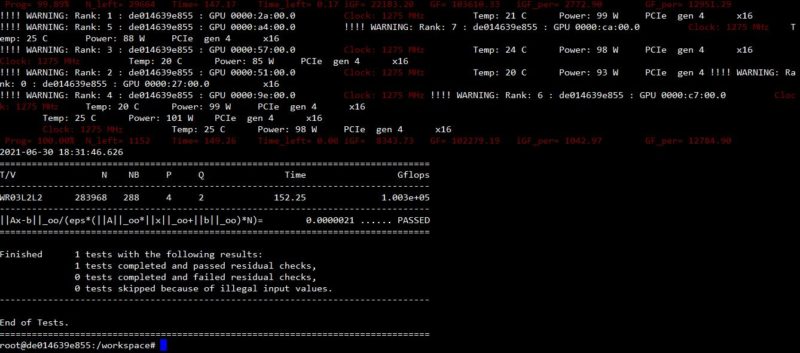

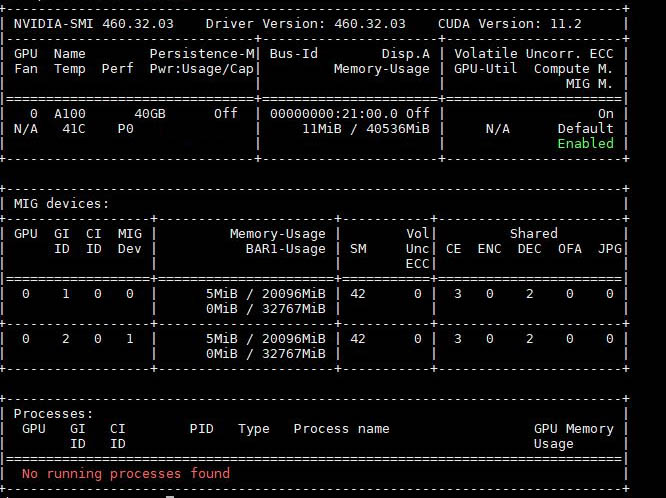

HGX A100 của NVIDIA bao gồm 8 GPU NVIDIA A100 80GB 500W, cung cấp tốc độ xử lý nhanh, tuy nhiên tiêu thụ năng lượng lớn lên tới 5kW. Với khả năng tính toán mở rộng và dung lượng bộ nhớ tích hợp đáng kể, GPU A100 có tính năng độc đáo gọi là MIG, cho phép phân vùng GPU thành các kích cỡ khác nhau giống như phiên bản đám mây. Tính năng này được sử dụng để tăng thông lượng của GPU trong các công việc suy luận AI song song, giúp quản lý tác vụ suy luận AI một cách hiệu quả.

Đây là những gì xảy ra khi chúng tôi chia NVIDIA A100 40 GB thành hai phiên bản MIG.

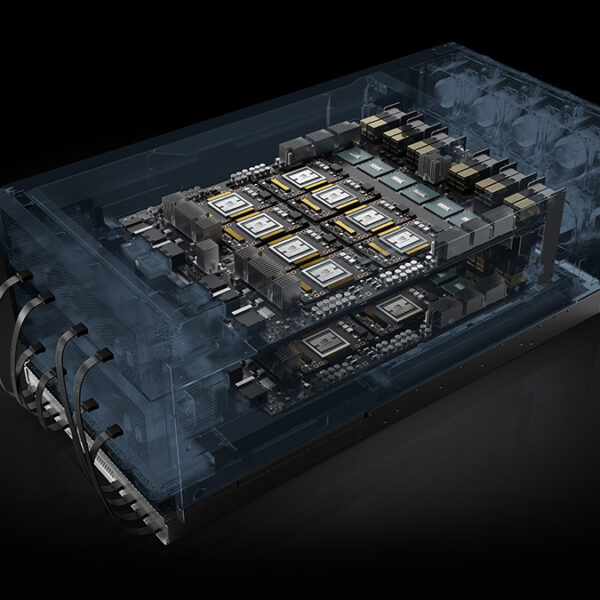

Như bạn có thể đã thấy, tất cả những điều này đòi hỏi RẤT NHIỀU sự làm mát. Đây là hai hệ thống NVIDIA A100, mặt trên làm mát bằng không khí, mặt dưới làm mát bằng chất lỏng.

Hệ thống làm mát bằng chất lỏng giúp tăng hiệu suất và cho phép chúng tôi chạy A100 ở giới hạn công suất cao hơn, nhờ đó tăng hiệu suất.